Разработчики социальной сети Facebook создали алгоритм Learn2Smile, способный не только анализировать выражение лица пользователя, но и реалистично реагировать на мимику собеседника.

Искусственный интеллект, лежащий в основе проекта, проанализировал записи 250 видеоконференций в Skype. Алгоритм «изучил» расположение 68 базовых точек на каждом из лиц во время разговора. На основе этих данных Learn2Smile составил каталог основных выражений лиц и невербальных сигналов. Реагируя на слова и эмоции собеседника, люди совершают несколько общих типов действий: кивают, наклоняют голову, моргают. Создатели алгоритма отмечают, что даже малозаметные движения рта и бровей могут быть крайне информативны.

В ходе тестирования проекта Learn2Smile получил анимированное «лицо», которое воспроизводит подходящее выражение в ответ на мимику пользователя. Например, если человек смеется, «лицо» видеобота приоткрывает рот и наклоняет голову определенным образом. Участники тестирования наблюдали за реакцией бота и одного из экспериментаторов на одно и то же видео. Мимика Learn2Smile показалась людям вполне реалистичной, его реакции не слишком отличались от реакций экспериментатора.

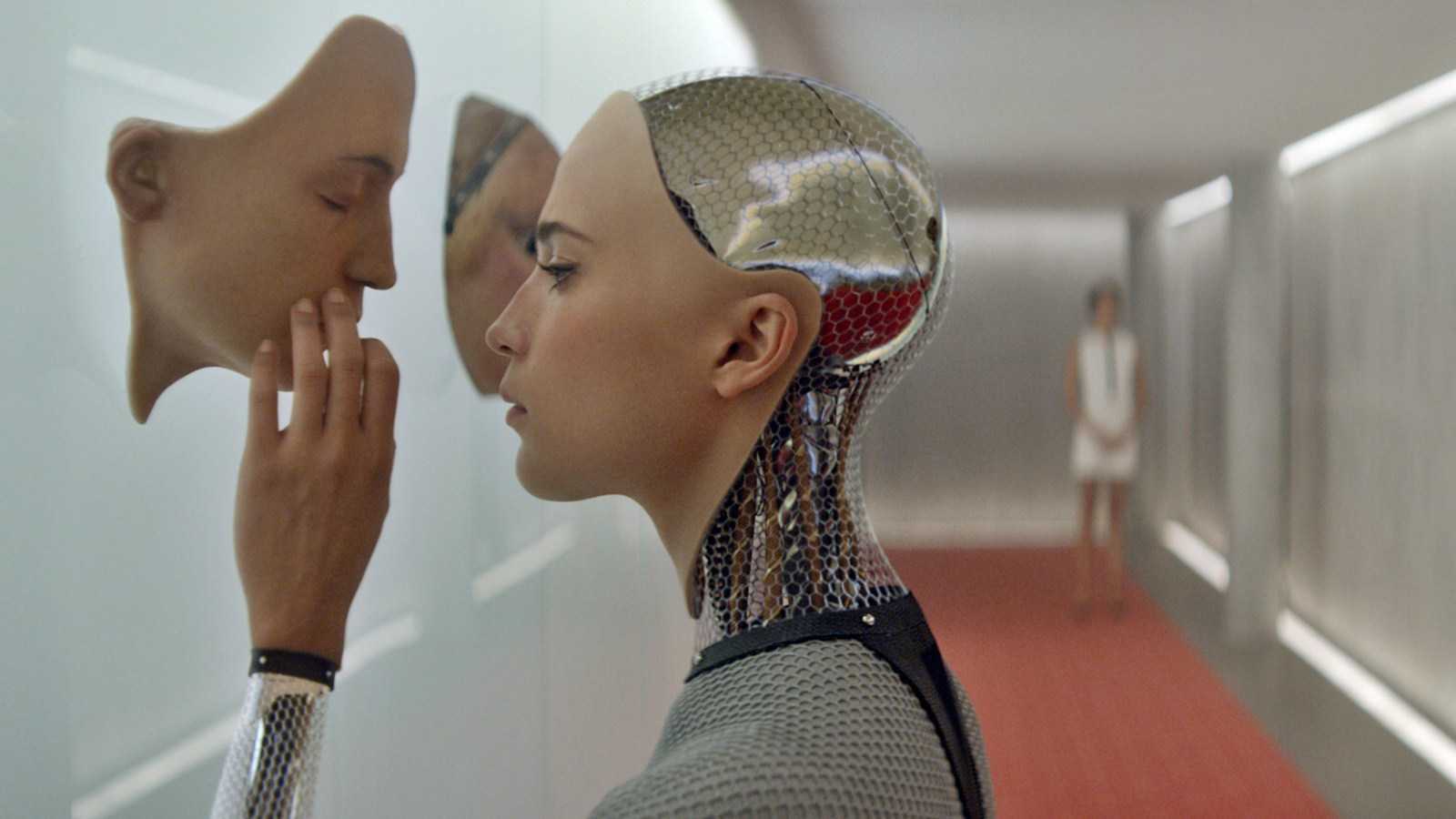

По словам разработчиков, их проект направлен на то, чтобы сделать общение с автоматическими видеопомощниками более комфортным для пользователей. В перспективе такие боты будут становиться все сложнее, их дизайн будет более детализированным, поэтому пользователи могут столкнуться с эффектом «зловещей долины». Это явление, при котором относительно похожие на человека объекты (роботы или куклы) вызывают у нас отвращение из-за мелких несоответствий человеческому образу — полной симметрии лица или неестественных движений.

Разработку представят на международной конференции International Conference on Intelligent Robots and Systems, посвященной проблемам развития робототехники и искусственного интеллекта.

Искусственный интеллект, лежащий в основе проекта, проанализировал записи 250 видеоконференций в Skype. Алгоритм «изучил» расположение 68 базовых точек на каждом из лиц во время разговора. На основе этих данных Learn2Smile составил каталог основных выражений лиц и невербальных сигналов. Реагируя на слова и эмоции собеседника, люди совершают несколько общих типов действий: кивают, наклоняют голову, моргают. Создатели алгоритма отмечают, что даже малозаметные движения рта и бровей могут быть крайне информативны.

В ходе тестирования проекта Learn2Smile получил анимированное «лицо», которое воспроизводит подходящее выражение в ответ на мимику пользователя. Например, если человек смеется, «лицо» видеобота приоткрывает рот и наклоняет голову определенным образом. Участники тестирования наблюдали за реакцией бота и одного из экспериментаторов на одно и то же видео. Мимика Learn2Smile показалась людям вполне реалистичной, его реакции не слишком отличались от реакций экспериментатора.

По словам разработчиков, их проект направлен на то, чтобы сделать общение с автоматическими видеопомощниками более комфортным для пользователей. В перспективе такие боты будут становиться все сложнее, их дизайн будет более детализированным, поэтому пользователи могут столкнуться с эффектом «зловещей долины». Это явление, при котором относительно похожие на человека объекты (роботы или куклы) вызывают у нас отвращение из-за мелких несоответствий человеческому образу — полной симметрии лица или неестественных движений.

Разработку представят на международной конференции International Conference on Intelligent Robots and Systems, посвященной проблемам развития робототехники и искусственного интеллекта.

[ Регистрация | Вход ]